ChatGPT-4.5 всё чаще воспринимается как человек в тестах

LLM практически невозможно отличить от живого человека

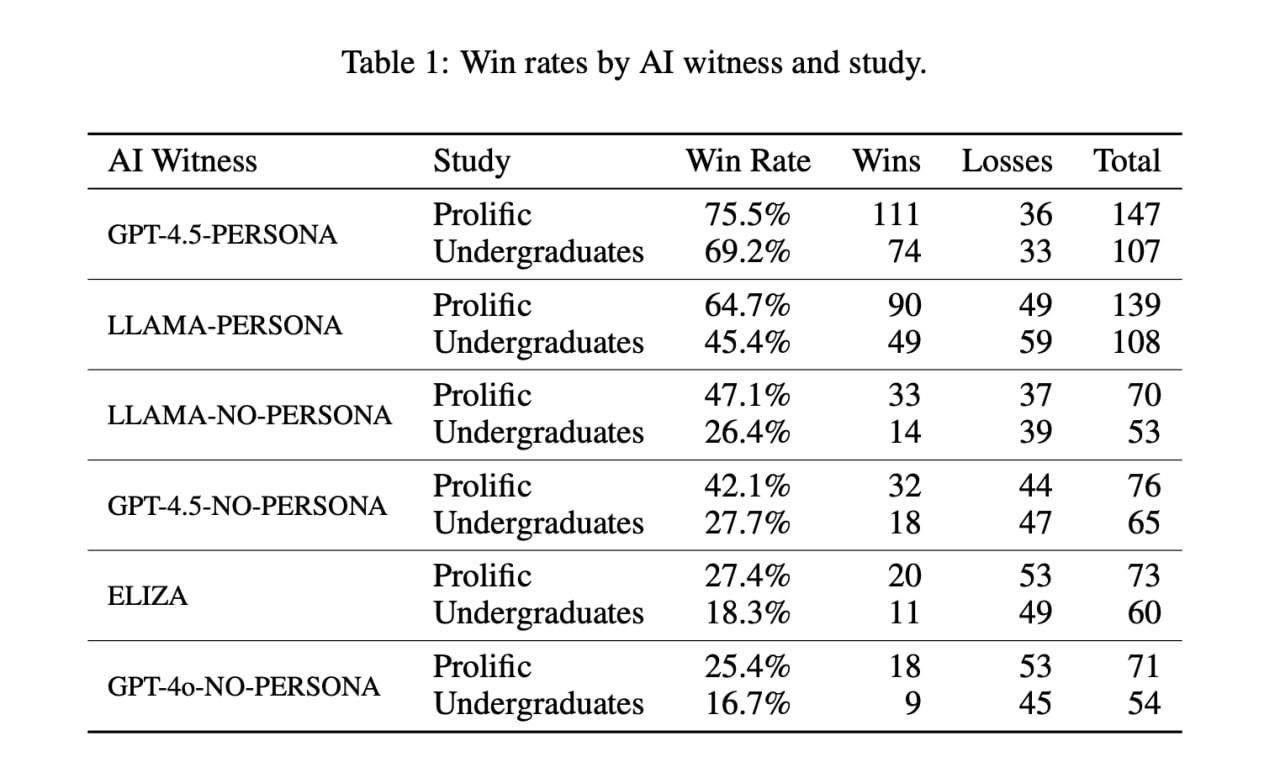

Недавнее исследование, проведенное учеными из Калифорнийского университета в Сан-Диего, продемонстрировало, что искусственный интеллект ChatGPT-4.5 способен обманывать пользователей, выдавая себя за человека. При проведении теста Тьюринга, три четверти участников приняли чат-бота за настоящего собеседника при наличии расширенной инструкции, которая описывала его личность и давала рекомендации по ведению беседы. В отличие от ChatGPT-4.5, модель Meta Llama 3.1‑405B смогла «спрятаться» за человеческим обликом лишь в 56 процентах случаев с расширенной инструкцией и в 38 процентах без неё. Это подтверждает, что правильная подготовка и подача информации играют ключевую роль в восприятии ИИ. Ранее, в 2022 году, ChatGPT-4, будучи новейшей версией, обманул участников в 67 процентах случаев, что свидетельствует о постоянном совершенствовании технологий искусственного интеллекта.

Методы проведения исследования

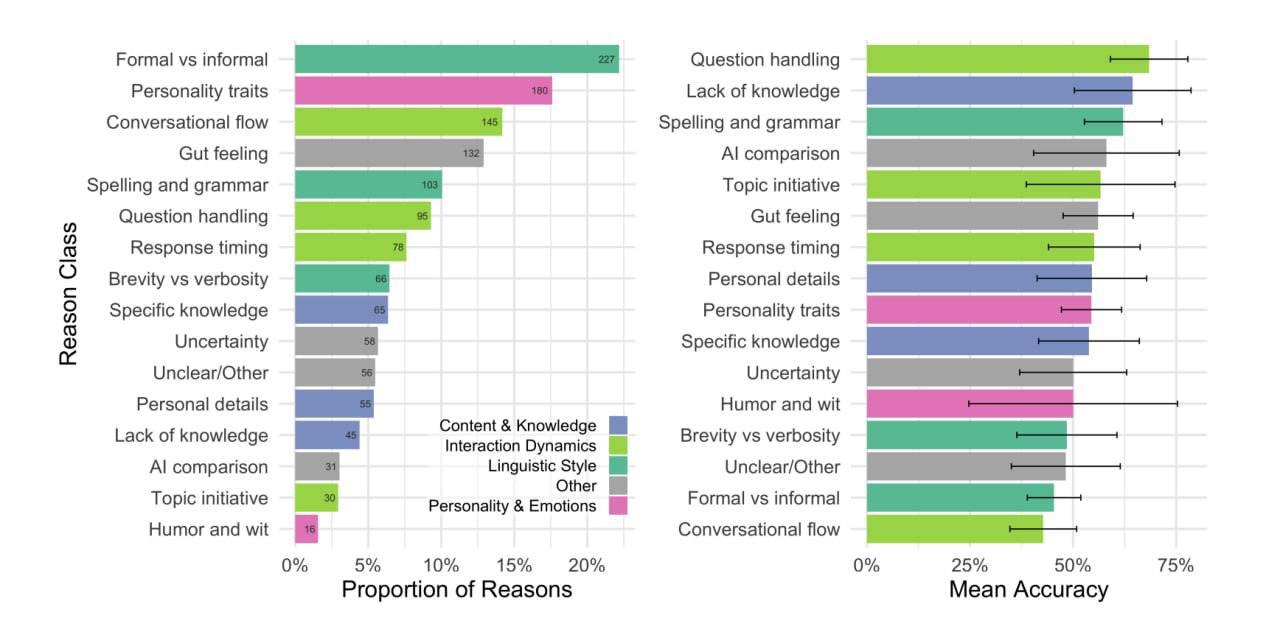

В рамках исследования авторы использовали разные подходы для сравнения способности чат-ботов к имитации человеческого общения. Испытуемые взаимодействовали с несколькими версиями искусственного интеллекта, включая ChatGPT-4.5 и модели от Meta, такие как Llama 3.1‑405B. Каждая из этих моделей получала либо минимальную инструкцию, которая содержала лишь основную техническую информацию о тесте Тьюринга, либо расширенную инструкцию, известную как Persona. Эта последняя версия включала в себя описание личности, за которую чат-бот должен был выступать, актуальные новости и рекомендации о том, как вести диалог в стиле обычных людей. Разделение инструкций позволило исследователям оценить, как представление информации влияет на восприятие искусственного интеллекта. Результаты показали, что более полное оформление инструкций значительно повышает вероятность того, что испытуемые примут чат-бота за человека, что подчеркивает важность контекста в взаимодействии с искусственным интеллектом.

Минимальная инструкция

Минимальная инструкция, используемая в тесте Тьюринга для чат-бота, была довольно скромной и содержала лишь базовые сведения. Она сообщала искусственному интеллекту о его участии в эксперименте, без каких-либо дополнительных заданий или контекста. Указания касались лишь технических аспектов, таких как формат общения, но не затрагивали личностные характеристики или стратегии взаимодействия, что делало чат-бота более уязвимым в условиях теста. Это ограничение, по сути, препятствовало способности нейросети демонстрировать более сложные и адаптивные модели поведения. В результате, когда ChatGPT-4.5 использовал только минимальную инструкцию, его успех в «обмане» участников снизился, что наглядно продемонстрировало важность контекста и дополнительной информации для достижения высоких результатов в таких тестах.

Расширенная инструкция Persona

Расширенная инструкция Persona была разработана для того, чтобы повысить эффективность общения чат-бота во время теста Тьюринга. Она включала в себя детальное описание личности, к которой должен был примерить себя искусственный интеллект, что позволяло ему имитировать человеческое поведение более правдоподобно. Важно, что в этой инструкции содержался также список актуальных новостей, что давало возможность боту быть в курсе происходящего и уметь поддерживать разговор на темы, интересующие людей в текущий момент. Подсказки о манерах поведения в переписке помогали чат-боту лучше учитывать нюансы человеческого общения, такие как интонация, эмоциональная окраска и контекстуальные отсылки. Все эти элементы сделали его ответы более естественными и близкими к тем, что могли бы дать настоящие собеседники, что, в свою очередь, способствовало тому, чтобы участники теста воспринимали его за человека в значительном числе случаев.

Результаты эксперимента

Результаты эксперимента произвели значительное впечатление на исследователей и общественность. Участники теста, взаимодействуя с ChatGPT-4.5, который получил специальные инструкции Persona, на 73% принимали его за реального человека. Это свидетельствует о высоком уровне убеждения, достигаемом при использовании продвинутых алгоритмов и настроек, направленных на имитацию человеческого общения. Важно отметить, что без таких указаний эффективность ChatGPT-4.5 значительно снизилась: его идентификация как человека происходила в два раза реже. В контексте сравнения, модель Llama 3.1‑405B с инструкцией Persona также продемонстрировала определенные успехи, обманывая участников в 56% случаев, однако без дополнительных указаний ее эффективность упала до 38%. Эти результаты подчеркивают важность не только самой модели ИИ, но и качества ее инструкций и контекста, в котором она функционирует.

Сравнение с предыдущими версиями

В исследовании, проведенном учеными из Калифорнийского университета в Сан-Диего, было показано, что модель ChatGPT-4.5 значительно превосходит своего предшественника, ChatGPT-3.5, в способности обмануть испытуемых во время теста Тьюринга. В прошлом году ChatGPT-4 продемонстрировал успех в 67% случаев, что уже тогда указывало на высокий уровень его имитации человеческой речи. В этом контексте стоит отметить, что версия 3.5 смогла «выдать себя» всего в 50% случаев, что подчеркивает заметный прогресс в работе нейросетей. Успех ChatGPT-4.5, который был принят за человека в 73% случаях, наглядно демонстрирует, как технологии искусственного интеллекта развиваются, что позволяет им более эффективно взаимодействовать с пользователями и, по сути, затруднять различение между человечеством и машинами. Так, каждое новое поколение нейросетей продолжает улучшать свои возможности, поднимая планку в области симуляции человеческого общения.

Тест Тьюринга

Тест Тьюринга был предложен Аланом Тьюрингом в 1950 году как способ оценки интеллекта машин. Его концепция заключается в том, что если испытуемый не может отличить ответы компьютера от ответов человека, значит, машина «проходит» тест и демонстрирует уровень разумности, сопоставимый с человеческим. В оригинальной версии теста участвуют три стороны: испытуемый, человек-посредник и компьютер. Задача испытуемого — определить, кто из собеседников является реально живым человеком. С течением времени тест стал не только важнейшим стандартом в области искусственного интеллекта, но и вдохновил на развитие новых технологий и методов взаимодействия между людьми и машинами. Он продолжает оставаться актуальным инструментом для оценки способности ИИ к имитации человеческого поведения и взаимодействия.

Заключение

Недавние исследования, проводимые учеными, показывают, что искусственный интеллект, особенно такие модели, как ChatGPT-4.5, с расширенными инструкциями, все чаще воспринимается пользователями как человек. Это явление открывает новые перспективы для применения ИИ в самых различных областях, включая обслуживание клиентов, автоматизацию процессов, создание контента и многие другие сферы. Использование таких технологий может значительно повысить эффективность и продуктивность, однако с этим прогрессом возникают и серьезные вопросы.

Во-первых, стоит задуматься о границах, до которых могут дойти технологии ИИ. Как далеко может затянуться исследование в области создания все более совершенных и человекоподобных систем? Также необходимо обсудить этические аспекты, связанные с использованием ИИ. Каковы нормы и правила, которые будут защищать пользователей от потенциальных злоупотреблений? Ответы на эти вопросы становятся важным шагом в создании сбалансированной и безопасной среды для взаимодействия человека и машины. Установление четких этических норм поможет не только предотвратить возможные риски, но и способствовать более гармоничному сосуществованию технологий и общества.